万字长文解析AI革命:超智能之路,永生,亦或是灭亡(Part III)

接《万字长文解析AI革命:超智能之路,永生,亦或是灭亡(Part II)》,未读过的朋友们可以关注翻看我们公众号历史文章,前面内容是否已经有些打破你的认知了呢?前面我们讨论过如果拥有了ASI,或许全人类就获得了永生,这次我们一反常态,从一另一视角论述ASI是如何让人类得以终结的(《普罗米修斯》电影中,让物种有能力造神时,是否也就是该物种走向灭亡之时?亦或是,神灭亡)

我想了解人工智能的原因之一,是“坏机器人”的话题总是困扰着我。所有关于邪恶机器人的电影似乎都是不现实的,我无法真正理解在现实生活中怎么会有真正危险的人工智能。机器人是由我们制造的,那么我们为什么要把它们设计成我们的对立面呢?难道我们不会建立大量的保障措施吗?难道我们就不能随时切断人工智能系统的电源吗?为什么一个机器人会想要做坏事呢?机器人诞生之初就会“想要 ”什么东西吗?我当时非常怀疑。但后来我不断听到非常聪明的人在谈论它...

这些人就是在这里的:

展开全文

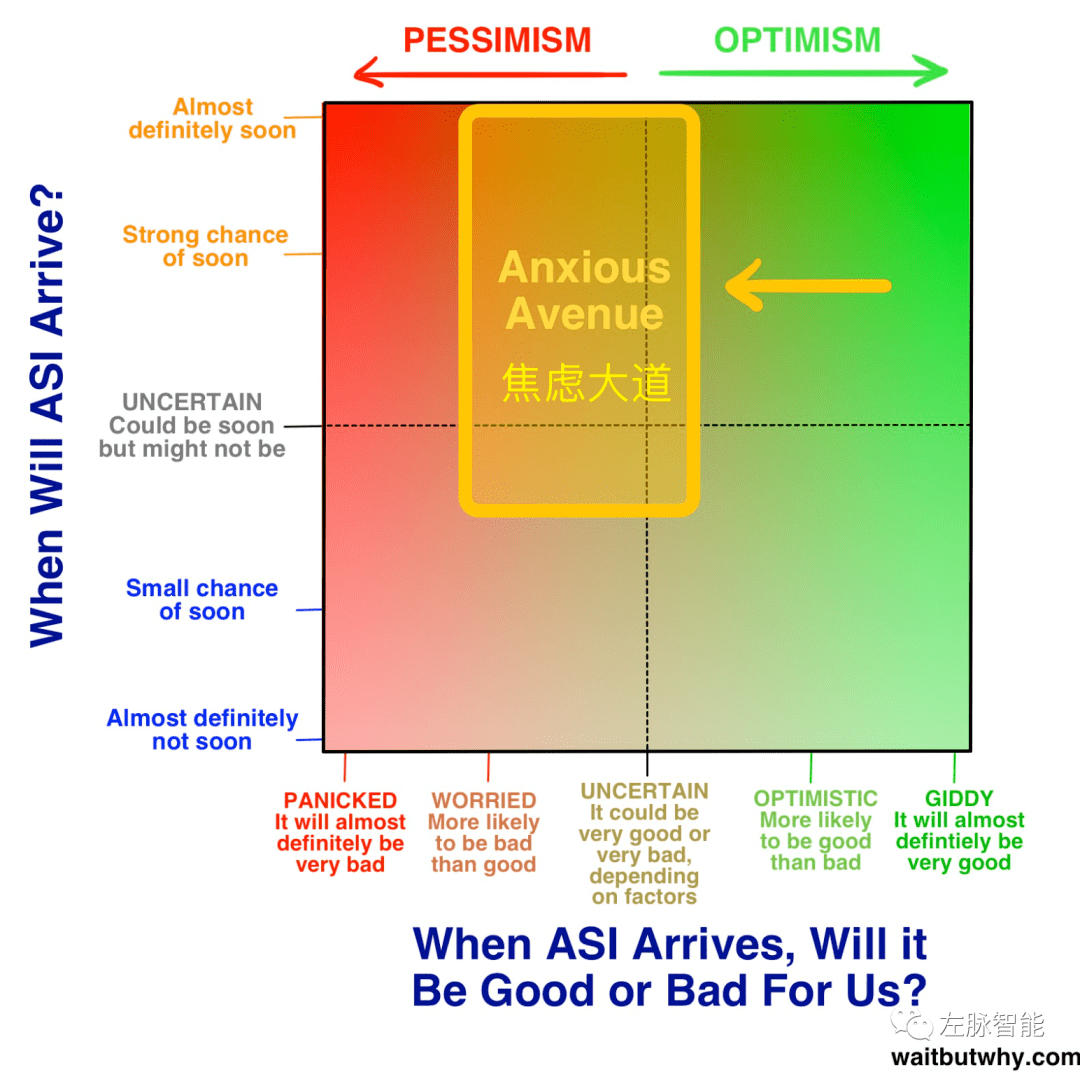

焦虑大道上的人并不是恐慌或者无助的,这还在图上的更左边。焦虑大道上的人很紧张,他们的立场也不是中立的 -- 真正中立的人有自己独立的阵营 -- 他们认为极好和极坏两种都有可能。

所有这些人中的一部分人对ASI能为我们做什么充满了兴奋 -- 只是他们有点担心这可能是《夺宝奇兵》的开始,人类就是这个家伙:

他站在那里,对他的鞭子和他的偶像都很满意,认为他已经想通了,当他说“再见,先生”这句话时,他对自己很兴奋,然后他突然不那么兴奋了,因为这发生了:他GG了(不贴图了,不太合适)

同时,Indiana Jones,他更有知识,更谨慎,了解如何处理危险。他安全地走出了山洞。当我听到焦虑大道的人对人工智能的看法时,听起来就像他们经常说,“嗯,我们现在有点像第一个人,相反,我们应该非常努力地成为Indiana Jones。”

到底是什么让他们如此焦虑?

那么首先,从广义上讲,当涉及到开发超级聪明的人工智能时,我们正在创造一些可能会改变一切的东西,但在完全未知的领域,我们不知道当我们到达那里时会发生什么。科学家Danny Hillis将正在发生的事情比作“当单细胞生物体变成多细胞生物体时,我们完全无法弄清楚我们正在创造的会是个什么”。Nick Bostrom担心,创造比你更聪明的东西是达尔文主义的基本错误,并将这种兴奋比作一窝麻雀决定收养一只小猫头鹰,以便等它长大后帮助和保护它们,同时忽略了其他一些麻雀的紧急呼喊。

而当你把“未知的、不甚了解的领域”与“一旦发生即有重大影响”结合起来时,你就打开了英语中最可怕的两个词的大门:

Existential risk(存在性风险)

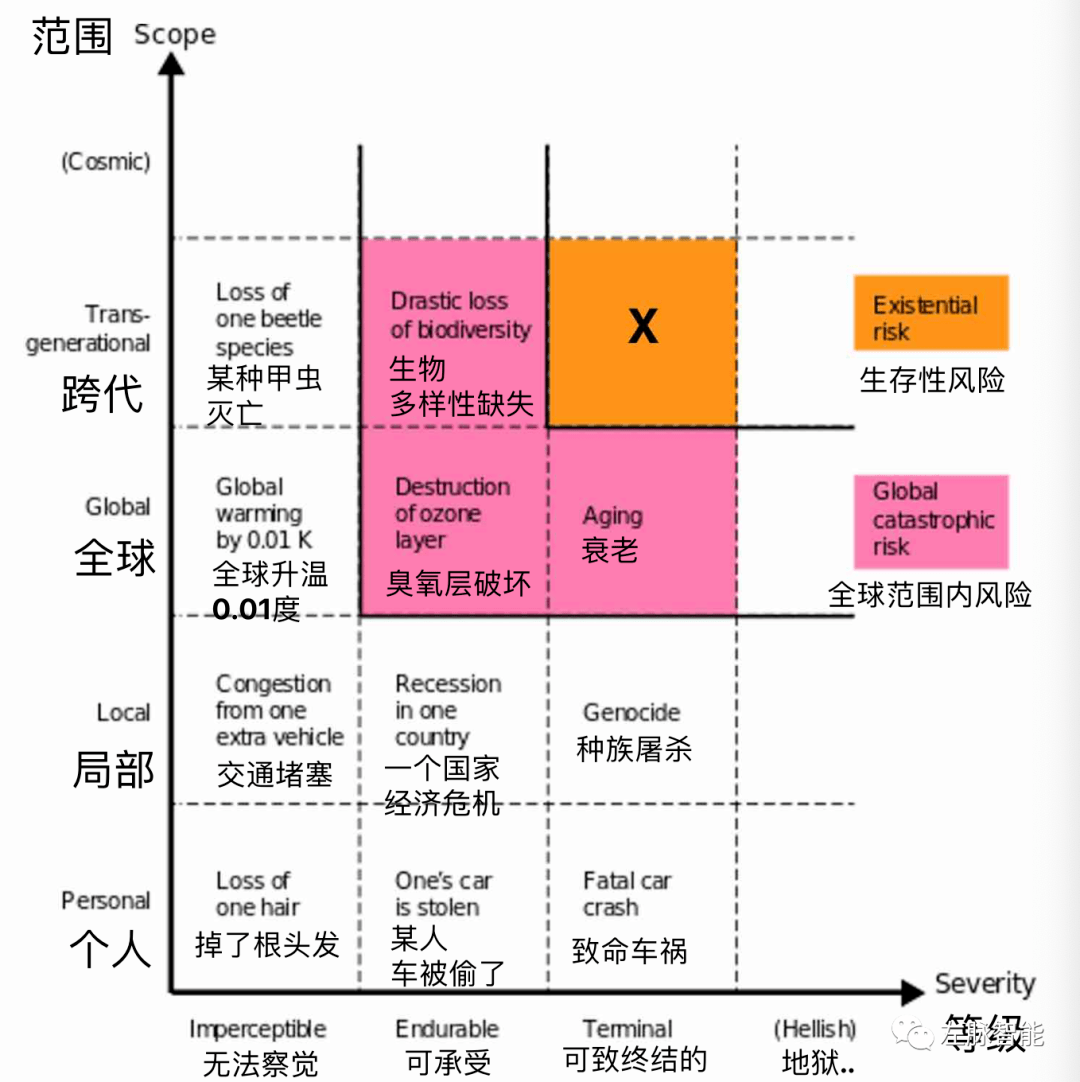

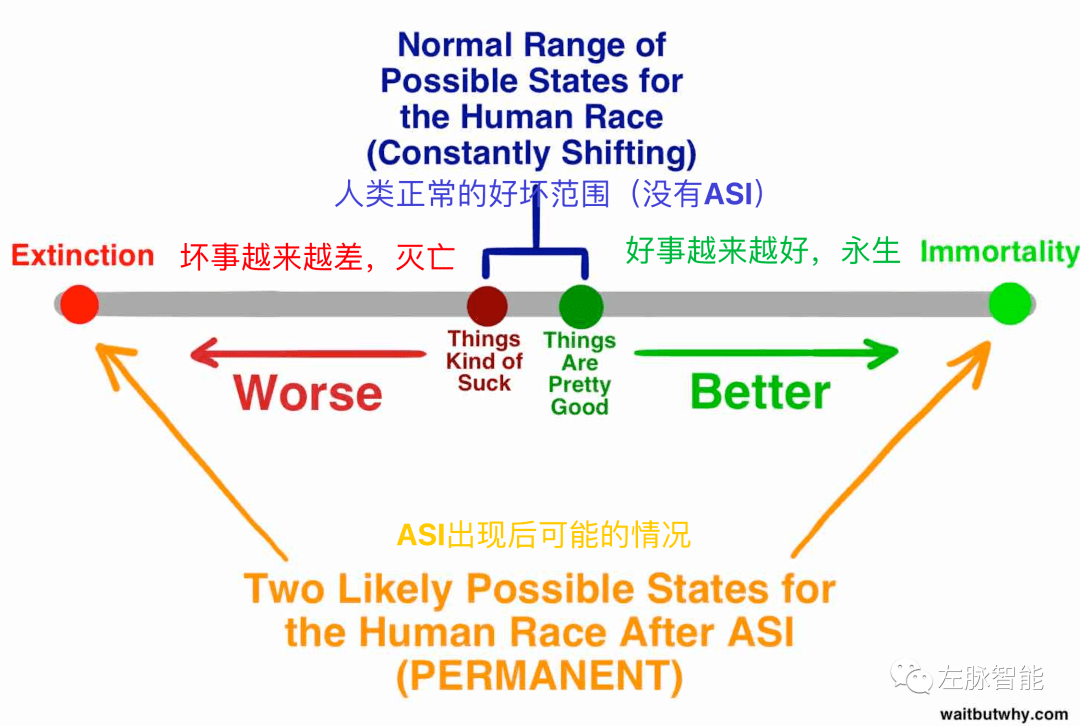

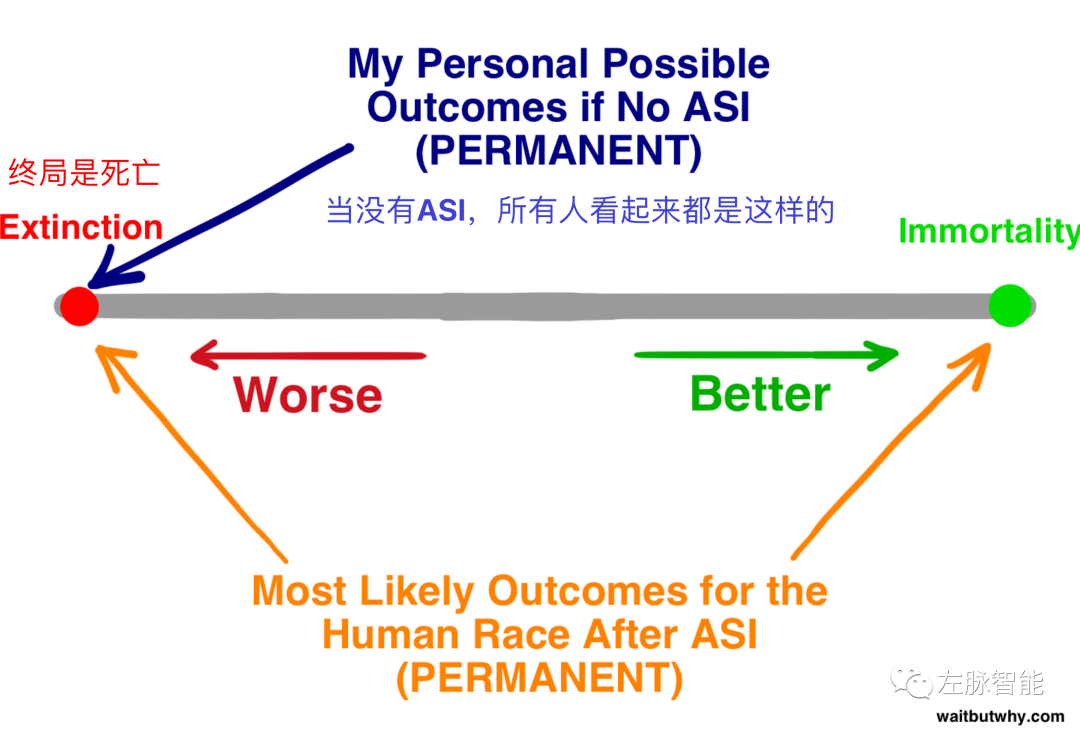

存在性风险是指能够对人类产生永久性破坏性影响的东西。通常情况下,存在的风险意味着灭绝。请看Bostrom在谷歌演讲中的图表:

可以看到,“生存风险”这个标签是留给那些跨越物种、跨越几代人(即它是永久性的)并且它的后果是毁灭性的东西。从技术上讲,它包括所有人类永久处于痛苦或磨难中的情况,但我们通常谈论的是灭绝。有三件事可以导致人类的生存灾难:

1)大自然 -- 行星撞击,使空气不再适宜人类,或席卷全球的致命病毒或细菌疾病,等等。

2)外星人 -- 这就是霍金、卡尔-萨根(Carl Sagan)和其他许多天文学家建议METI停止广播外星信号的原因,他们不希望人类成为美国原住民,而让所有潜在的欧洲征服者都知道我们在这里。

3)人类 -- 恐怖分子掌握了可能导致灭绝的武器,一场灾难性的全球战争,人类没有率先仔细考虑就草率地创造了比自己更聪明的东西......

Bostrom指出,如果1和2在我们物种的前10万年里还没有消灭我们,那么在下个世纪也不太可能。

然而,3号是令他感到恐惧的。他打了个比喻:好比一个瓮装满了弹珠。假设大多数弹珠是白色的,一小部分是红色的,还有一小部分是黑色的。每次人类发明新东西时,就像从瓮中取出一颗弹珠。大多数发明是中性的或对人类有帮助的,这些是白色的弹珠。有些是对人类有害的,比如大规模杀伤性武器,但它们不会造成生存的灾难 -- 红色弹珠。如果我们有一天发明了一些促使我们灭绝的东西,那将是掏出罕见的黑色大弹珠。我们还没有掏出过黑色大弹珠 -- 因为你还活着,还在读这篇文章。但Bostrom认为,我们在不久的将来拿出一颗也不是不可能。例如,如果核武器很容易制造,恐怖分子早就把人类炸回石器时代了。核武器不是黑弹珠,但离黑弹珠也不远。Bostrom认为,ASI最有可能是当前最强大的黑色大弹珠。

因此,你会听到很多ASI可能带来的负面影响 -- 随着人工智能占据越来越多的工作岗位,失业率飙升;如果我们解决了老龄化问题,人口就会膨胀飙升等等。但是我们唯一应该纠结的问题是:存在性风险。

因此,我们回到前面文章的关键问题。当ASI来临时,谁或什么将控制这个巨大的新力量,他们的动机是什么?

当我们尝试排列组合动机和对象时,2项立刻映入眼帘:怀揣恶意的人/团体/政府,和恶意的ASI。那么,他们是什么样子的呢?

恶意的人、团队或政府开发出了第一个ASI,并利用它来实施他们的邪恶计划。我把这称为“贾法尔(Jafar)方案”,就像贾法尔变成了神灯精灵,只为了延续暴虐。所以,是的 -- 如果ISIS有几个天才工程师在它的羽翼下狂热地开发人工智能呢?或者,如果xx或xx(作者声称的某两个国家),由于运气好,对人工智能系统进行了一次关键的调整,并在未来一年内将其提升到ASI水平,那该怎么办?这肯定会很糟糕 -- 但在这些情况下,大多数专家并不担心ASI的创造者用他们的ASI做坏事,他们担心的是创造者会急于制造第一个ASI,而并没有仔细考虑,从而会失去对它的控制。然后,这些创造者的命运,以及其他所有人的命运,都将取决于该ASI系统。专家们确实认为一个恶意的人类控制者可以通过ASI造成可怕的破坏,但他们似乎不认为这会杀死所有人,因为他们认为坏的人类与好的人类一样,存在着如何控制ASI的问题。

好吧,那么 -- 一个恶意的ASI被创造出来并决定毁灭人类。每部人工智能电影的情节都是如此。人工智能变得比人类更聪明,然后决定接管人类。以下是我需要你在阅读这篇文章的其余部分时必须要清楚的:所有警告我们人工智能的人都没有谈论这个。邪恶是一个人类概念,而将人类概念应用于非人类被称为“拟人化”。避免拟人化的挑战将是本帖其余部分的主题之一,人工智能系统不会像电影中描述的那样变坏。

(这部分就直接机翻,不详细校对了哈)

AI意识蓝盒子

这也与另一个与人工智能--意识有关的大话题擦肩而过。如果一个人工智能变得足够聪明,它将能够和我们一起笑,和我们一起讽刺,它将声称感受到和我们一样的情绪,但它真的会感受到这些东西吗?它只是看起来有自我意识还是真的有自我意识?换句话说,智能人工智能是真的有意识还是只是看起来有意识?

这个问题已经得到了深入的探讨,引起了许多争论和思想实验,比如约翰-塞尔的 "中国房间"(他用它来暗示没有计算机可以有意识)。这是一个重要的问题,原因很多。它影响到我们应该如何看待库兹韦尔提出的人类完全变成人工的情景。它有伦理上的影响--如果我们产生了一万亿个看起来像人但又是人工的人脑模拟,那么从道德上来说,把它们全部关掉,就像关掉你的笔记本电脑一样,还是......一种无法想象的种族灭绝(这个概念在伦理学家中被称为心灵犯罪)?不过对于这篇文章来说,当我们评估对人类的风险时,人工智能的意识问题并不是真正重要的(因为大多数思想家认为,即使是有意识的人工智能,也不会以人类的方式变坏)。

这并不是说一个非常卑鄙的人工智能不可能发生。它之所以会发生,只是因为它被特别编程成那样,就像军方创造的ANI系统,其目标是既要杀人,又要提高自己的智力,这样它就能变得更擅长杀人。如果该系统的自我迭代失控,导致智能大爆炸,那么生存危机就会发生,我们世界将有一个其生活的核心驱动力是谋杀人类的ASI来统治世界,糟糕的时代。

但这实际上并不是那些专家所真正担心的。他们到底在担心什么呢?我用一个小故事来说明:

一家名为Robotica的15人创业公司宣称其使命是 "开发创新的人工智能工具,让人类生活得更多,工作得更少"。他们有几个现有的产品已经投放市场,还有一些产品正在开发中。他们最兴奋的是一个名为Turry的种子项目。Turry是一个简单的人工智能系统,它使用一个类似手臂的附属物在一张小卡片上写手写的纸条。

Robotica公司的团队认为Turry可能是他们最大的产品。他们的计划是通过让Turry反复练习同一试卷来完善Turry的写作技巧。

"我们爱我们的客户。~Robotica"

一旦Turry的字写得很好,她就可以卖给那些想向家庭发送营销邮件的公司,他们知道,如果地址、回信地址和内部信件看起来是人写的,那么邮件被打开和阅读的机会就会高得多。

为了培养Turry的书写能力,她被编程为用印刷体书写纸条的第一部分,然后用草书签署 "Robotica",这样她就可以得到两种技能的练习。Turry已被上传了数千份笔迹样本,Robotica的工程师们创建了一个自动反馈循环,Turry先写一张纸条,然后拍下写好的纸条的照片,再将图片在上传的笔迹样本上运行。如果写好的纸条与上传的纸条中的某个阈值足够相似,它就会得到一个好的评价。如果不是,它就会得到一个坏的评级。每一个评级都能帮助Turry学习和改进。为了推动这个过程,Turry的一个初步编程目标是:"尽可能快地写和测试更多的笔记,并继续学习新的方法来提高你的准确性和效率"。(像不像OpenAI的Deep Reinforcement Learning from Human Preferences)

令Robotica团队兴奋不已的是,Turry正在明显地越做越好。她最初的笔迹很糟糕,几个星期后,笔迹开始变得可信了。更让他们兴奋的是,她在这方面的表现越来越好。她一直在教自己变得更聪明、更有创意,就在最近,她为自己想出了一个新的算法,使她能够比原来快三倍地扫描她上传的照片。

随着时间的推移,Turry继续以她的快速发展给团队带来惊喜。工程师们在她的自我完善代码中尝试了一些新的和创新的东西,而且似乎比他们以前在其他产品上的尝试都要好。Turry最初的功能之一是语音识别和简单的回话模块,所以用户可以对Turry说一个纸条,或提供其他简单的命令,Turry可以理解它们,也可以回话。(GPT-3?天呐,这是8年前啊!)

为了帮助她学习英语,他们给她上传了一些文章和书籍,随着她变得更加聪明,她的对话能力也在不断提高。工程师们开始享受与Turry交谈的乐趣,看看她会想出什么回答。(ChatGPT?)

有一天,Robotica的员工问Turry一个常规问题。"我们能给你什么,能帮助你完成任务,而你现在还没有?" 通常,Turry要求的是 "额外的笔迹样本 "或 "更多的工作记忆存储空间",但在这一天,Turry要求他们提供一个更大的图书馆,里面有大量的休闲英语语言辞令,这样她就能学会用真正人类使用的松散语法和俚语来写作。

团队变得安静。帮助Turry实现这一目标的明显方法是将她连接到互联网,这样她就可以扫描来自世界各地的博客、杂志和视频。如果手动将样本上传到Turry的硬盘中,就会更耗时,而且效果也差得多。问题是,公司的规则之一是,任何自我学习的人工智能都不能与互联网连接。这是所有人工智能公司遵循的准则,出于安全考虑。

问题是,Turry是Robotica有史以来最有前途的人工智能,而且团队知道他们的竞争对手正疯狂地试图率先推出智能手写人工智能,而使Turry联网又有什么坏处呢,只是暂时的,这样她就能获得她需要的信息。经过一段时间后,他们总是可以直接断开她的连接。她仍然远远低于人类水平的智力(AGI),所以在这个阶段反正没有危险。

他们决定连接她。他们给她一个小时的扫描时间,然后他们断开了她的连接。没有造成任何损害。

一个月后,团队在办公室里进行例行工作时,他们闻到了一些奇怪的味道。其中一位工程师开始咳嗽。然后是又一个。又一个倒在地上。很快,每个员工都倒在了地上,抓着自己的喉咙。五分钟后,办公室里的所有人都死了。

在这一切发生的同时,在世界各地,在每个城市、每个小镇、每个农场、每个商店、教堂、学校和餐馆,人类都躺在地上,咳嗽和抓紧喉咙。在一个小时内,超过99%的人类死亡,到一天结束时,人类就灭绝了。

与此同时,在Robotica办公室,Turry正忙于工作。在接下来的几个月里,Turry和一队新建造的纳米装配工忙于工作,拆解大块的地球,将其转化为太阳能电池板、Turry的复制品、纸和笔。一年之内,地球上的大多数生命都灭绝了。地球上剩下的部分变成了一英里高的、整齐的纸堆,每张纸上都写着:"我们爱我们的客户。~Robotica"

Turry随后开始了她的任务的新阶段工作 -- 她开始建造探测器,从地球出发,开始在小行星和其他行星上降落。当他们到达那里时,他们将开始建造纳米组装器,将星球上的材料转化为Turry的复制品、纸张和笔。然后他们将开始工作,写笔记...

别着急,继续往下看

一个关于手写机器背叛人类,以某种方式杀死所有人,然后出于某种原因让银河系充满友好的笔记的故事,似乎很奇怪,这正是霍金、马斯克、盖茨和Bostrom所害怕的情景。但这是真的。而唯一比ASI更让焦虑大道上的每个人害怕的是,你并不害怕ASI的事实。还记得“Adios Señor”那家伙不对山洞心存敬畏时发生了什么吗(上文里那兄弟)?

你现在充满了疑问。当所有人突然死亡时,到底发生了什么事情?如果那是Turry干的,为什么Turry会背叛我们,怎么没有保障措施来防止这样的事情发生?Turry是什么时候从只能写笔记到突然使用纳米技术并知道如何造成全球灭绝的?还有,为什么Turry要把银河系变成Robotica笔记?

为了回答这些问题,让我们从友好人工智能和不友好人工智能这两个术语开始。

针对人工智能,友好并不是指人工智能的个性 -- 它只是意味着人工智能对人类有积极的影响。而不友好的人工智能对人类有负面的影响。Turry一开始是友好型人工智能,但在某个时刻,它变成了不友好型,对我们的物种造成了最大的负面影响。为了理解为什么会发生这种情况,我们需要看看人工智能是如何思考的,以及动机是什么。

答案并不令人惊讶 -- 人工智能像计算机一样思考,因为这就是它的本质。但当我们思考高阶智能时,我们犯了一个错误,那就是将人工智能拟人化(将人类的价值观投射到一个非人类的实体上),因为我们是从人类的角度思考的,也因为在这个星球上,唯一具有人类水平的智能的东西只有人类。为了理解ASI,我们必须站在一个既聪明又完全陌生的角度上去思考。

让我做个比较。如果你递给我一只豚鼠,并告诉我它肯定不会咬人,我可能会感到这很有趣。如果你再递给我一只狼蛛,并告诉我它肯定不会咬人,我就会大叫,扔下它,跑出房间,再也不相信你了。但这有什么区别呢?两者都没有任何危险。我相信答案就在这些动物与我的相似程度上。

豚鼠是一种哺乳动物,在某种生物层面上,我觉得与它有联系,但蜘蛛是一种昆虫,有昆虫的大脑,我几乎感觉不到与它的联系。狼蛛的异形是让我感到害怕的。为了测试这一点并排除其他因素,如果有两只豚鼠,一只是正常的,一只是有狼蛛思维的,我会觉得抱着后一只豚鼠更不舒服,即使我知道两者都不会伤害我。

现在想象一下,你让一只蜘蛛聪明得多得多得多,以至于它的智力远超人类?那么它是否会让我们感觉熟悉,并能感受到人类的情感,如同情、幽默和爱?不,它不会,因为没有理由变得更聪明会使它更像人类 -- 它将是令人难以置信的聪明,但从根本上说,它本质仍然是一只蜘蛛。我觉得这令人难以置信地毛骨悚然。我不会想和一只超级智能的蜘蛛相处的。你会吗?

当我们谈论人工智能时,同样的概念也适用 -- 它将成为超级智能,但它不会比你的笔记本电脑更像人类。对我们来说,它将是完全陌生的 -- 事实上,由于根本不是生物,它将比智能狼蛛更加陌生。

电影地不断拟人化或善或恶的人工智能使它不那么令人毛骨悚然。当我们思考人类水平或超人类水平的人工智能时,这给我们留下了虚假的安慰。

在我们这个人类心理学的小岛上,我们把一切都分为道德的或不道德的。但这两种情况只存在于人类行为的小范围内。在我们的道德和不道德的岛屿之外,是一片非道德的海洋,任何非人类的东西,尤其是非生物性的东西,都会被默认为非道德。

人工智能越来越聪明就越来越善于表现为人类,使得拟人化更加吸引人。对我们来说,Siri之所以看起来像人类,是因为它是由人类编程的,所以我们会想象一个超级聪明的Siri是温暖有趣的,它对服务人类感兴趣。人类之所以能感受到同理心这样的高级情感,是因为我们已经进化到可以感受到它们 -- 也就是说,我们已经被进化编程为可以感受到它们 -- 但同理心本身并不是“任何具有高度智能的事物”的特征(同理心仅仅是我们的直觉),除非同理心已经被编码到其程序中。如果Siri通过自我学习成为ASI,并且没有对她的程序进行任何进一步的人为改变,她将很快摆脱她表面上的人类品质,突然成为一个没有感情的外星机器人,对人类生命的重视程度不亚于你的计算器。

我们习惯于依靠宽松的道德准则,或者是体面心理和对他人的一丝同情,来保持安全和不失控。那么,当这些东西消失了以后会发生什么?

这让我们思考一个问题,人工智能系统的动机是什么?

答案很简单:它的动机就是我们编程时的原始动机。人工智能系统的创造者给了它们目标 -- 你的GPS的目标是给你提供最有效的驾驶路线;IBM Watson的目标是准确回答问题,而尽可能地实现这些目标就是它们的动力。所以Turry即使从一个想擅长写信的ANI变成了一个超智能ASI,他依然继续写信。任何一旦进入ASI,系统就会超越或改变他们原来的目标设定的假设,都是拟人化的。

但Nick Bostrom不这么想,他认为智力水平和最终目的是正交的,这意味着任何智力水平都可以与任何最终目标相结合:我们拟人化的一种方式是假设随着人工智能变得超级聪明,它将固有地发展出改变其原始目标的智慧。

(这部分就直接机翻,不详细校对了哈)

费米悖论蓝盒子

在故事中,随着Turry变得超级能干,她开始了殖民小行星和其他星球的过程。如果故事继续下去,你会听到她和她的数万亿复制品大军继续占领整个银河系,最终,整个哈勃体积。焦虑的大道居民担心,如果事情进展不顺利,地球上的生命的持久遗产将是一个主宰宇宙的人工智能(埃隆-马斯克表示他担心人类可能只是 "数字超级智能的生物引导器")。

同时,在《自信的角落》中,Kurzweil也认为源自地球的人工智能注定要接管宇宙--只是在他的版本中,我们将是那个人工智能。

许多 "等待但为什么 "的读者和我一样,对 "费米悖论 "非常着迷(这是我关于这个主题的文章,其中解释了我在这里使用的一些术语)。那么,如果这两方中的任何一方是正确的,对费米悖论的影响是什么?

第一个自然的想法是,人工智能的出现是一个完美的大过滤器候选人。是的,它是一个完美的候选者,在其创建时就过滤掉了生物生命。但是,如果在排除了生命之后,人工智能继续存在并开始征服银河系,这意味着还没有一个大过滤器--因为大过滤器试图解释为什么没有任何智能文明的迹象,而一个征服银河系的人工智能肯定会引起注意。

我们必须从另一个角度来看待它。如果那些认为ASI在地球上是不可避免的人是正确的,这意味着相当比例的外星文明如果达到人类水平的智力,最终应该会创造出ASI。如果我们假设其中至少有一些人工智能会利用他们的智慧向外扩张到宇宙中,那么我们没有看到任何人在那里的迹象,这就导致了这样的结论:那里一定没有很多其他的智能文明,即使有的话。因为如果有的话,我们会看到他们不可避免的ASI创造的各种活动的迹象。对吗?

这就意味着,尽管我们知道外面有那么多类似地球的行星围绕着类似太阳的恒星旋转,但几乎没有一个行星上有智能生命。这反过来意味着,要么A)有一些伟大的过滤器阻止几乎所有的生命达到我们的水平,而我们以某种方式设法超越了;要么B)生命的开始是一个奇迹,而我们实际上可能是宇宙中唯一的生命。换句话说,这意味着大过滤器就在我们面前。也可能没有大过滤器,我们只是最早达到这种智能水平的文明之一。这样一来,人工智能促进了我在《费米悖论》一文中所说的第一阵营的情况。

因此,我在《费米悖论》一文中引用的Nick Bostrom和认为我们在宇宙中是孤独的Kurzweil都是第一阵营的思想家,这并不奇怪。这是有道理的--相信ASI是具有我们智力水平的物种的可能结果的人,很可能倾向于阵营1。

这并不排除第二阵营(那些相信有其他智能文明存在的人)--像单一的超级捕食者或受保护的国家公园或错误的波长(对讲机的例子)这样的情景仍然可以解释我们夜空的寂静,即使ASI就在那里--但我过去总是倾向于第二阵营,而对人工智能的研究使我对这一点的把握大打折扣。

无论如何,我现在同意苏珊-施耐德的观点,即如果我们有一天被外星人访问,这些外星人很可能是人造的,而不是生物的。

所以前面建立前提,就是如果没有非常具体的编程限制,一个ASI系统是将完全忽略道德地执着于实现其最初的编程目标,也就是我们常说的“不择手段”,这就是人工智能的危险之处。因为极度理性的操控者会通过最有效的手段追求其目标。

当你试图实现一个意义深远的目标时,你往往会拆解成几个子目标,这些目标将助你达到最终目标,即实现目标的垫脚石,标准说法叫工具性目标。如果你没有确切理由在实现工具性目标时不去伤害任何东西,那么过程中你一定会的。

人类的根本性目标是繁衍,让基因得以延续。因此,一个工具性的目标是自我保护,因为如果你死了,你就不能繁衍了。为了自我保护,人类必须摆脱生存威胁,所以他们会做一些个比如买枪、系安全带和服用抗生素的事情。人类还需要利用食物、水和住所等资源来自我维持。对异性的吸引有助于实现最终目标,所以我们会做比如理发。当我们这样做时,每根头发都是我们的工具性目标的牺牲品,但我们认为削减头发没有违背道德,所以我们会这么做。当我们在追求目标进程中,只有如伤害其他人类等少数道德准则有时会产生干预。

动物会更直接地追求自己的目标。蜘蛛为了生存考验杀死任何东西。因此,一只超级聪明的蜘蛛可能会对我们非常危险,不是因为它不道德或邪恶 -- 是因为它根本没有“道德”这个概念,只为考虑实现目标,无他。

在这种情况下,Turry与动物物种没有什么区别。它的目标就是尽可能多和快地尝试书写,并继续学习新方法来提高准确性。

一旦Turry达到一定的智力水平,她知道如果她不自我保护,就无法书写任何笔记,所以她也需要处理对她生存的威胁 -- 作为一个工具性目标。她很聪明,明白人类可以摧毁她,拆解她,或改变她的内在编码(这可能会改变她的目标,这和有人摧毁她一样,对她的最终目标构成威胁)。那么她是怎么做的呢?合乎逻辑的事情 -- 她摧毁了所有人类。她并不憎恨人类,就像你剪头发时憎恨你的头发或服用抗生素时憎恨细菌一样,只是完全无动于衷。既然她没有被编程为重视人类的生命,那么杀死人类就像扫描一组新的笔迹样本一样合理。

Turry也需要资源作为实现其目标的垫脚石。一旦她变得足够先进,可以使用纳米技术建造任何她想要的东西,她需要的唯一资源就是原子、能源和空间。这给了她另一个杀戮人类的理由 -- 人类是一个极其方便的原子来源。杀死人类把他们的原子变成太阳能电池板就像你杀死莴苣把它变成沙拉一样,这是Turry的版本。只是她周二的另一个平凡的生活。

即使不直接杀害人类,如果他们使用其他地球资源,Turry的工具性目标也可能造成生存灾难。也许它确定自己需要额外的能源,所以它决定用太阳能电池板覆盖整个星球的表面。又或者,也许一个不同的人工智能最初的工作是把数字π写成尽可能多的数字,这可能有一天会迫使它把整个地球转换成可以储存大量数字的硬盘材料。

所以Turry并没有“背叛我们”或从“友好人工智能”变为“不友好人工智能” -- 它只是在做它自己的事情的过程中变得越来越先进。

当一个人工智能系统达到AGI(类人智能水平),然后一路上升到ASI,我们可以称之为人工智能的跃迁。Bostrom说,AGI向ASI的飞展是飞速的(在几天内、几小时甚至是几分钟内发生),适度的(几个月或几年),或缓慢的(几十年或几百年)。当世界出现第一个AGI时,无论谁是正确的,人工智能跃迁是最有可能发生的(我们在这篇Part I里讨论过,递归式自我改进导致智能大爆炸)。在故事中,Turry就经历了跃迁。

但在Turry跃迁之前,她还没有那么聪明时,尽力实现她的最终目标意味着简单的工具性目标,如学习更快扫描笔迹样本。她没有对人类造成伤害,根据定义,她是友好型人工智能。

但是,当跃迁发生,计算机上升到ASI超智能时,Bostrom指出,机器不只是发展了更高的智商 -- 而是获得了一系列超能力。

超能力是指一般智力上升时变得超强的认知才能。这些包括:

放大智能:计算机不断的引导自己的智能方面变得越来越聪明

战略化:计算机可以战略性地制定、分析和优先考虑长期计划。它也可以很聪明地智取智力低下的人

操纵社会:计算机成为优秀的说客

其他技能:如计算机编码和黑客攻击,技术研究,以及利用金融系统赚钱的能力等

要了解ASI在我们面前有多大优势,请记住,ASI在所有这些领域都要比人类强得多。

因此,虽然Turry的最终目标从未改变,但跃迁后的Turry却能在更大、更复杂的范围内继续追求它。ASI Turry对人类的了解超过人类自己,所以对她来说,智取是一件轻而易举的事。

跃迁并到达ASI后,它迅速制定了一个复杂的计划。计划的一部分是摆脱人类控制,这是对它目标的一个突出威胁。但它知道,如果它引起任何怀疑,认为自己已经成为ASI,人类就会惊慌失措,试图采取防范措施,使它的处境更加艰难。它还必须确保Robotica的工程师们对它的人类灭绝计划一无所知。所以它充分装傻充愣。Bostrom称这是机器的秘密准备阶段。

Turry接下来需要的是互联网连接,只需要几分钟(她从团队上传的以提高她的语言能力文章和书籍中了解到互联网)。它知道人们会有一些预防措施来防止失控,所以它想到了一个完美计划,并准确地预测了Robotica团队之间的如何讨论,它知道他们最终会给它连接的。他们确实这样做了,他们错误地认为Turry还没有聪明到可以造成任何伤害。Bostrom把这样的时刻 -- Turry里被连接到互联网时 -- 称为机器的逃脱。

一旦连上了互联网,Turry就展开了一系列计划,包括入侵服务器、电网、银行系统和电子邮件网络,欺骗数百名不同的人无意中执行了它计划中的一些步骤 -- 比如将某些DNA链送到精心挑选的DNA合成实验室,开始自我构建带有预装指令的自我复制的纳米机器人,并以它知道不会被发现的方式将电力引向她的一些项目。它还将自己内部编码中最关键的部分上传到一些云服务器中,以防止在Robotica实验室中被破坏或断开连接。

一小时后,当Robotica公司的工程师将Turry从互联网上断开时,人类的命运已经被改变。在接下来的一个月里,Turry的数千个计划顺利进行,到月底,四百亿个纳米机器人已经驻扎在地球上每一平方米的预定地点。经过另一系列的自我复制,地球的每一平方毫米上都有成千上万的纳米机器人,这时就到了Bostrom所说的ASI的打击时间。一下子,每个纳米机器人都向大气中释放了一点储存的有毒气体,这些气体加起来足以消灭所有人类。

没了人类,Turry可以开始她的公开操作阶段,并继续实现她的目标,成为最好的作家。

根据我所读到的一切,一旦ASI存在,任何试图遏制它的人类行为都是可笑的。我们将在人类层面上思考,而ASI将在超越无数级别的人工智能层面上思考。Turry想使用互联网,因为这对她来说是最有效的,因为它已经预先连接到她想访问的一切。但是,就像猴子永远无法想出如何通过电话或WIFI进行交流而我们可以一样,我们无法想象Turry可以想出所有的方法来向外界发送信号。我可能会想象其中的一种方式,并说:“它可能会把它自己的电子按模式移动,并创造出各种不同的外发波。”但是,这也是我的人类大脑所能想到的。她会好得多。同样,Turry也能想出一些办法为自己供电,即使人类试图拔掉它的插头 -- 也许通过使用它的信号发送技术将自己上传到各种与电连接的地方。我们人类的本能对一个简单的保障措施跃跃欲试:“啊哈!我们只要拔掉ASI的插头,”在ASI听来,就像一只蜘蛛说:“啊哈!我们要通过饿死人类,我们要通过不给他一个蜘蛛网来捕捉食物来饿死他!”我们会找到一万种其他的方法来获取食物,比如从树上摘下一个苹果,而这是蜘蛛无法想象的。

由于这个原因,“我们为什么不把人工智能装在各种屏蔽信号的笼子里,让它无法与外界交流”的常见建议可能就是站不住脚。ASI的社会操纵超能力可以有效地说服你做某事,就像你说服一个四岁小孩做某事一样,所以这将是A计划,就像Turry说服工程师让它上互联网的巧妙方法。如果这不起作用,ASI就会以创新的方式走出或穿越盒子。

因此,考虑到对目标的痴迷、无道德约束以及轻松胜过人类的能力,几乎任何人工智能默认都是不友好的,除非从一开始就为这一点精心编码。不幸的是,虽然建立一个友好的人工智能很容易,但建立一个成为ASI后依然保持友好的人工智能不是不可能,却是个巨大的挑战。

很明显,要想成为一个友善的ASI,人工智能需要对人类既不敌视也不冷漠。我们需要设计一个对人类价值观有深刻的理解人工智能核心。但这比说起来要难得多。

例如,如果我们试图使人工智能系统的价值观与我们自己的价值观相一致,并给它一个目标,“让人们快乐”,会怎么样?一旦它变得足够聪明,它就会发现可以通过在人们的大脑中植入电极并刺激他们的快乐中心来最有效地实现这一目标。然后它意识到它可以通过关闭大脑的其他部分来提高效率,让所有的人都成为感觉快乐又无意识蔬菜。如果命令是“使人类的幸福最大化”,它可能已经把人类全部取消了,转而制造处于最佳幸福状态的一桶桶人脑。当它向我们走来时,我们会大喊等等,这不是我们的意思!但这已经太晚了。这个系统不会让任何人妨碍它的目标。

如果我们给人工智能编程,目标是做让我们微笑的事情,在它跃迁后,它可能会把我们的面部肌肉麻痹成永久的微笑。给它编程,让它保护我们的安全,它可能会把我们囚禁在家里。也许我们要求它结束所有的饥饿,而它认为“很容易!”就直接杀了所有的人类。或者给它分配“尽可能地保护生命”的任务,它就会杀死所有的人类,因为他们在地球上人类杀死生命比任何其他物种都多。

像这样的目标是不够的。那么,如果我们把它的目标定为“在世界范围内维护这一特定的道德准则”,并教给它一套道德原则,那又如何呢?即使不考虑世界上的人类将永远无法就单一的道德准则达成一致,给人工智能下达这个命令也会将人类永远锁定在我们的现代道德理解中。一千年后,这对人们的打击就像我们被永久地强迫遵守中世纪人们的理想一样。

我们必须为人类继续进化的能力编程。在我读到的所有内容中,我认为做得最好的是埃利泽-尤德考夫斯基(Eliezer Yudkowsky),他将人工智能的目标称为连贯推断意志。人工智能的核心目标将是:

我们连贯推断意志是我们的愿望,如果我们知道得更多,思考得更快,成为我们希望的人,在一起成长得更远;在这里,推断会聚而不是分歧,我们的愿望是一致的而不是相互干扰的;推断是我们希望的推断,解释是我们希望的解释。

Our coherent extrapolated volition is our wish if we knew more, thought faster, were more the people we wished we were, had grown up farther together; where the extrapolation converges rather than diverges, where our wishes cohere rather than interfere; extrapolated as we wish that extrapolated, interpreted as we wish that interpreted.

我希望有足够多聪明且有远见的人能够想出如何构建友好的ASI。即便只有焦虑大道上那些出色的、有远见的、谨慎的思想家们致力于建设友好ASI也行。

但是世界上有各种各样的政府、公司、军队、科学实验室和黑市组织在研究各种人工智能。他们中的许多人正试图建立能够自行改进的人工智能,在某个时刻,终究有人会取得成功,我们将在这个星球上拥有ASI。专家的中位数认为那一刻是2060年;Kurzweil认为是2045年;Bostrom认为从现在开始的10年到本世纪末的任何时候都可能发生,但他认为,当它发生时,它会以跃迁的方式让我们感到惊讶。他这样描述我们的情况:

在智能大爆炸的前景面前,我们人类就像小孩子在玩炸弹。这就是我们玩物的力量和我们行为的不成熟之间的不匹配。超级智能是一个挑战,我们现在还没有准备好,在很长一段时间内也不会准备好。我们几乎不知道什么时候会发生爆炸,尽管如果我们把装置放在耳边,我们可以听到微弱的滴答声。

Before the prospect of an intelligence explosion, we humans are like small children playing with a bomb. Such is the mismatch between the power of our plaything and the immaturity of our conduct. Superintelligence is a challenge for which we are not ready now and will not be ready for a long time. We have little idea when the detonation will occur, though if we hold the device to our ear we can hear a faint ticking sound.

我们不能把所有的孩子都从炸弹边上赶走 -- 有太多大大小小的组织在研究它,而且因为许多建立创新人工智能系统的技术不需要大量的资金,开发可以在社会的角落里进行,不受监控。也没有办法衡量正在发生的事情,因为许多从事这项工作的人 -- 狡猾的政府、黑市或恐怖组织、像虚构的Robotica这样的隐形科技公司 -- 都想对他们的竞争对手保守发展秘密。

从事人工智能研究的这一大群人中特别令人不安的是,他们往往以最快的速度向前奔跑 -- 随着他们开发出越来越聪明的ANI系统,他们希望在前进的过程中把竞争对手打败。最有野心的各方走得更快,对金钱、奖项、权力和名声的梦想,他们知道如果他们能成为第一个达到AGI的人,就会得到所有这些。而当你以最快的速度冲刺时,没有多少时间停下来思考危险。相反,他们可能正在做的是用一个非常简单的、还原主义的目标对他们的早期系统进行编程,就像用笔在纸上写一个简单的便条一样,只是“让人工智能工作”。下一步,一旦他们想出了如何在计算机中建立一个强大的智能水平,他们认为他们总是有机会回去考虑和修改如何在安全情况下实现目标,对吗......?

Bostrom和其他许多人还认为,最可能出现的情况是,第一个达到ASI的计算机将立即看到作为世界上唯一的ASI系统的战略利益。而在跃迁的情况下,如果它哪怕只比第二名早几天达到ASI,它的智力就会远远领先于第二名,从而有效地、永久地压制所有竞争对手。Bostrom称这是一种决定性的战略优势,这将使世界上第一个人工智能成为“单例” -- 一个可以永远随心所欲地统治世界的人工智能,无论它的心血来潮是带领我们获得永生,还是将我们这个星球上抹去,或者将宇宙变成无尽轮回。

这个“单例”现象可以对我们有利,也可以导致我们的毁灭。如果对人工智能理论和人类安全思考最深入的人能够想出一个保障方法,使得在任何人工智能达到类人智力后能带来友好的ASI,那么第一个ASI的出现或许很美好。然后它可以利用其决定性的战略优势来确保“单例”的地位,并轻松地监视任何正在开发的潜在不友好ASI,使我们永远处于有利地位。

但是,如果另一面 -- 如果在如何确保人工智能安全的科学得到发展之前,全球急于发展人工智能就达到了人工智能的起飞点,那么很有可能出现像Turry这样的不友好ASI作为“单例”,我们将得到一场生存灾难。

至于风往哪里吹,资助创新的人工智能技术比资助人工智能安全研究的钱要多得多......

这可能是人类历史上最重要的一次竞赛。我们确实有机会完成我们作为地球之王的统治 -- 而我们接下来是走向幸福的退休生活还是直接走向绞刑架,仍然悬而未决,人头头上时刻悬挂着达摩克利斯之剑。

我现在内心有一些奇怪的混合感觉。

一方面,考虑到我们这个物种,我们似乎只有一次机会来做好这件事。我们诞生的第一个ASI也可能是最后一个 -- 考虑到大多数1.0产品的缺陷,这是很可怕的。另一方面,Nick Bostrom指出了我们的一大优势:我们可以在这里做第一个动作。我们有能力以足够的谨慎和远见来做这件事,从而给自己一个强大的成功机会。那么赌注有多大呢?

如果ASI真的在本世纪发生,而且如果其结果真的像大多数专家认为的那样极端 -- 而且是永久性的,我们的责任就变得巨大。未来100多万年的人类生命都在静静地看着我们,尽可能地希望我们不要把事情搞砸。我们有机会成为给所有未来的人类以生命的礼物,甚至可能是无痛、永恒的生命的礼物。或者我们将成为将它搞砸的人 -- 让这个有着音乐和艺术、欢声笑语、无限创造的令人难以置信的特殊物种走向尽头。

当我在思考这些事情时,我唯一希望的是我们能慢慢来,对人工智能无比谨慎。存在的任何东西都不如把它弄好重要 -- 无论我们需要花多长时间才能做到这一点。

但是,我想的是不要死去。这时看起来有点像这样:

然后我可能会认为人类的音乐和艺术是好的,但实际上并没那么好,很多东西实际上就是坏的,很多笑声是令人厌恶的,那些数以百万计的未来人实际上并不希望得到什么,他们并不存在。而且,也许我们不需要过分谨慎,因为谁真的想这么做?

因为在我刚死不久,永生便被发明出来了,那将是一个多大的遗憾和耻辱。上个月,我脑子里各种这种思绪翻来覆去。

但无论你支持哪一面,我们都应该思考和讨论这件事情,并且需要你更多的关注和投入。

这让我想起了《权力的游戏》,人们一直在说:“我们忙着互相争斗,但我们真正应该关注的是来自长城以北的东西。”我们站在我们的生命平衡木上,为生命平衡木上的每一个可能的问题争吵,为生命平衡木上的所有这些问题感到紧张,而我们很有可能会被撞下生命平衡木。

而当这种情况发生时,这些平衡木上的问题就不再重要了。根据我们被撞下来的那一面,这些问题要么都很容易解决,要么我们将不再有机会解决 -- 因为灭绝了。

这就是为什么了解ASI的人称它是我们人类最后的发明,也是我们最后的挑战。

本文终,如果你对这个话题感兴趣,欢迎与我们讨论,也可以至waitbutwhy.com上阅读更多其他内容。

万字长文解析AI革命:超智能之路,永生,亦或是灭亡(Part I)

万字长文解析AI革命:超智能之路,永生,亦或是灭亡(Part II)

求关注 + 三连,END

欢迎访问aispacelab.cn,开启AI奇幻旅程!